GPT-4o测试:多项能力相对之前提高

电影《她》中的场景似乎正在成为现实。OpenAI最新推出的旗舰大模型GPT-4o,不仅免费向公众开放,而且具备听、看、说的综合能力,响应速度流畅无延迟,仿佛与真人视频通话一般。

GPT-4o在直播中的表现尤为出色,能够感知用户的呼吸节奏,以更丰富的语气实时回复,并且支持随时打断对话。"o"代表"Omni",意味着全能,它可以接受文本、音频和图像的任意组合作为输入,并生成相应的文本、音频和图像输出。

GPT-4o的响应速度非常快,在短短232毫秒到平均320毫秒的时间内就能响应音频输入,与人类的对话反应速度相当。这一能力将免费提供给所有用户,包括GPT-4o和ChatGPT Plus会员版的所有功能,如视觉、联网、记忆、执行代码和GPT Store等。

此外,GPT-4o的语音模式将在几周内首先向Plus用户开放。在发布会现场,CTO Murati表示,GPT-4级别的模型已经向公众开放,而研究员William Fedus透露,GPT-4o是之前在大模型竞技场进行A/B测试的模型之一,表现出色,ELO分数领先。

GPT-4o还将提供API,价格优惠50%,速度提升一倍,单位时间内的调用次数是原来的5倍。网友们已经开始设想GPT-4o的各种应用,如辅助视障人士感知世界,以及提供比之前更出色的语音交互体验。

在发布会现场,总裁Brockman进行了精彩的演示,展示了GPT-4o在实时对话、翻译和视觉识别方面的能力。他还发布了一段5分钟的详细演示视频,展示了两个ChatGPT之间的对话和歌唱,戏剧感十足。

Brockman首先向旧版ChatGPT(小O)介绍了情况,然后向新版ChatGPT(小N)展示了视觉能力。接着,小O和小N就Brockman的衣着、房间风格等话题展开了对话。在Brockman的引导下,小O和小N甚至开启了对唱模式,旋律悠扬,音色逼真。

GPT-4o之所以能够实现如此出色的表现,是因为它采用了端到端训练的神经网络,能够同时处理语音、文本和图像。这使得GPT-4o在语音翻译和视觉理解方面都超越了OpenAI的专门模型和其他竞争对手。

虽然这次OpenAI没有发布详细的技术论文或报告,但有学者表示,一个成功的演示相当于1000篇论文。GPT-4o的推出,无疑为人工智能领域带来了新的突破,让人们对未来的智能助手充满了期待。

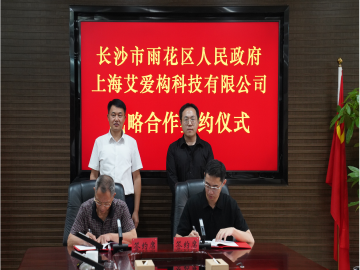

AI构与长沙市雨花区人民政府签订战略合作协议

AI构与长沙市雨花区人民政府签订战略合作协议

AI构与上海宝山区国企达成战略合作,共建智能管理新生态,开创

AI构与上海宝山区国企达成战略合作,共建智能管理新生态,开创

AI构携手金砖财经共绘“中国·再设计”蓝图,2024金砖论坛

AI构携手金砖财经共绘“中国·再设计”蓝图,2024金砖论坛

AI构与联博基金签署战略合作协议,共启政府招商新篇章

AI构与联博基金签署战略合作协议,共启政府招商新篇章